AIGC动态欢迎阅读

创飞Gemini 1.5!微软来砸谷歌场子了(doge)

关键字:上下文,模型,腾讯,窗口,长度文章来源:量子位

内容字数:4934字内容摘要:

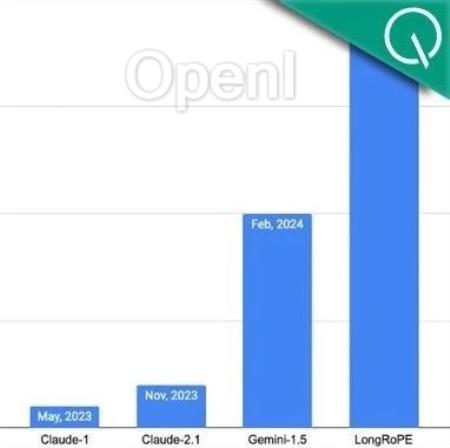

西风 发自 凹非寺量子位 | 公众号 QbitAI谷歌刚刷新大模型上下文窗口长度记录,发布支持100万token的Gemini 1.5,微软就来砸场子了。

推出大模型上下文窗口拉长新方法——LongRoPE,一口气将上下文拉至2048k token,也就是200多万!

并且1000步微调内,即可完成从短上下文到长上下文的扩展,同时保持原来短上下文窗口性能,也就是说训练成本和时间又省了一大笔。

网友看不下去了,直呼“谷歌太惨了”:

此外值得一提的是,这次LongRoPE为纯华人团队,论文一作Yiran Ding,就读于杭州电子科技大学,于实习期间完成该项工作。

LongRoPE究竟长啥样?先来看一波测试效果。

拿LLaMA2和Mistral试试水上下文窗口有效拉长,语言模型长文本理解能力可以得到很大提高。研究人员在LLaMA2-7B和Mistral-7B上应用LongRoPE,从三个方面评估了其性能。

第一项测试是在长文档上评估扩展上下文语言模型的困惑度。

在256k以内的评估长度上,研究人员使用Proof-pile和PG19数据集来进行测试。

LongRoPE在4k-256k的文本长度原文链接:200万上下文窗口创飞Gemini 1.5!微软来砸谷歌场子了(doge)

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破