AIGC动态欢迎阅读

原标题:哪里要动点哪里!腾讯联合清华、港科大推出全新图生视频大模型关键字:解读,腾讯,模型,视频,团队

文章来源:AI前线

内容字数:4058字内容摘要:

整理 | 傅宇琪

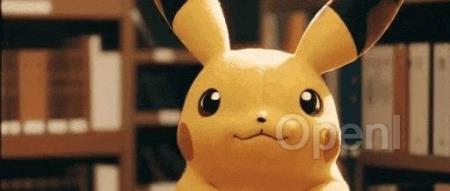

只需轻轻一点,静态的皮卡丘就会露出灿烂笑容:

咖啡会源源不断地冒出热气:

漂亮姐姐会朝你眨眼:

以上这些效果,均来自一个新的图生视频模型 Follow-Your-Click,由腾讯混元、清华大学和香港科技大学联合推出。

这个模型使用起来也非常简单:

把任意一张照片输入模型👉点击想选中的区域👉加上少量简单的提示词(如:动作、神态等)👉图片中原本静态的区域就能动起来。

相关研究论文已经在 arXiv 上公开,GitHub 上也放出代码,目前已经揽星 440+。

论文链接:https://arxiv.org/pdf/2403.08268.pdf

代码链接:https://github.com/mayuelala/FollowYourClick哪里要动点哪里通过进一步测试,可以发现 Follow-Your-Click 能够精准控制画面的动态区域。

点击画面主体,它就能够控制火箭发射和汽车行驶:

也能够生成“大笑”、“生气”、“震惊”的表情:

同样是鸟图,点击小鸟,输入“摇头”、“扇翅膀”、“跳舞”,都能得到相应更精确的动作:总之,就是想要哪里动,就点哪里。

研究团队还将原文链接:哪里要动点哪里!腾讯联合清华、港科大推出全新图生视频大模型

联系作者

文章来源:AI前线

作者微信:ai-front

作者简介:面向AI爱好者、开发者和科学家,提供大模型最新资讯、AI技术分享干货、一线业界实践案例,助你全面拥抱AIGC。