AIGC动态欢迎阅读

原标题:苹果极致LLM端侧方案:LLM in a flash

关键字:神经元,参数,知乎,侵权,加载文章来源:算法邦

内容字数:11197字内容摘要:

700个开发硬件免费申请➕现金大奖!生成式 AI、机器人 AI、PC AI 三大赛道!AMD Pervasive AI 开发者挑战赛报名火热进行中,扫码了解详情并报名~导读本文是知乎作者Civ对苹果端侧方案:LLM in a flash工作的整理总结,文内主要介绍了苹果如何从三个不同方面,利用闪存来解决大模型塞进手机时遇到的内存不足的问题。

原文地址:

https://zhuanlan.zhihu.com/p/673775476

本文只做学术分享,如有侵权,联系删文。端侧LLM毫无疑问会成为各手机厂商在2024年的主战场。从国内各手机厂透露的信息来看,大家几乎都把希望寄托在了芯片厂身上,自身能做的、会做的工作太少。希望苹果的工作对国内厂商们有启发、借鉴意义。

论文链接:LLM in a flash: Efficient Large Language Model Inference with Limited Memory

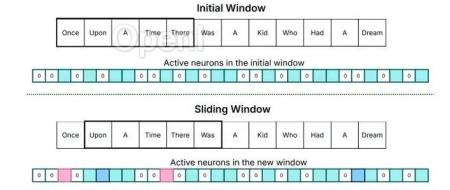

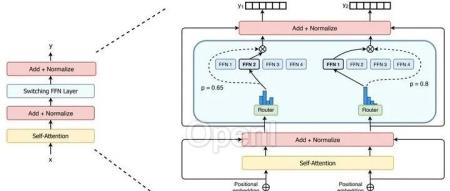

01Flash Memory and DRAM在移动端设备中(如手机),DRAM可理解为“运行时内存”,Flash Memory可理解为“存储空间”。做一个简单的类比,原文链接:苹果极致LLM端侧方案:LLM in a flash

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:智猩猩矩阵账号之一,连接青年AI学者,讲解研究成果,分享系统思考。