AIGC动态欢迎阅读

!

关键字:模型,语言,样本,问题,基准文章来源:量子位

内容字数:4717字内容摘要:

陈林 投稿 凹非寺量子位 | 公众号 QbitAI大模型不看图,竟也能正确回答视觉问题?!

中科大、香港中文大学、上海AI Lab的研究团队团队意外发现了这一离奇现象。

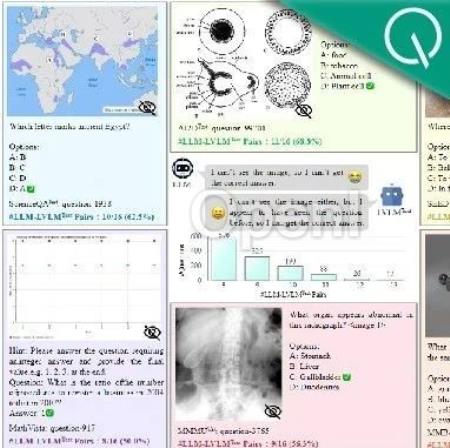

他们首先看到像GPT-4V、GeminiPro、Qwen1.5-72B、Yi-VL-34B以及LLaVA-Next-34B等大模型,不管是闭源还是开源,语言模型还是多模态,竟然只根据在多模态基准MMMU测试中的问题和选项文本,就能获得不错的成绩。

△蓝色表示能看到图的LVLMs,橘色和绿色分别表示只接收问题和选项文本的LLMs和LVLMs(LLM:大语言模型;LVLMs:多模态大模型)

不知道的还以为是大模型的隐藏技能被发现了。

有网友发出灵魂拷问:我们评估多模态模型的方法正确吗?

这一结果也激起了研究者们的好奇,于是他们决定对此展开进一步探究。

大模型隐藏技能被发现?针对现有的评估样本和评估过程,研究人员认为造成这种现象的两个主要问题。

第一,一些多模态评估样本缺少对视觉内容的依赖性。

这种问题反映了现有的benchmark中的不合理之处。这个问题包含了两种情况:

一种是有些评估样本的答案可以被蕴含在了题目和选项中从原文链接:中科大等意外发现:大模型不看图也能正确回答视觉问题!

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破